Analyse faciale et labiale

Dans le cadre du projet FRAPéOR et RePhon-IA nous avons besoin d’explorer des pistes de systèmes d’analyse de vidéo d’apprenant en temps réel . Les Objectifs de ce système sont de pouvoir détecter l’état de l’apprenant : niveau d’anxiété, de stress, tiques nerveux afin de contrôler le bon déroulement de la séance de formation. Les signes perceptibles sur le visage doivent nous aider à adapter le processus et éventuellement à l’orienter vers des pauses et de terminer la séance de formation.

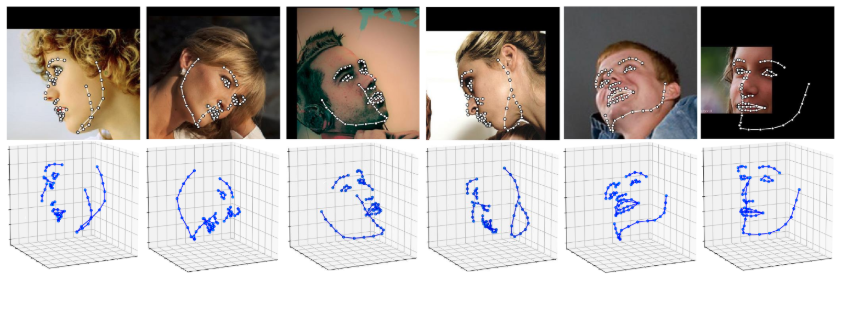

Dans ce domaine plusieurs projets de recherche sont actuellement menés pour mettre au point des méthodes de lecture faciale et labiale. On peut citer des projets autour de LipNet d’Oxford. Exemple de mise en oeuvre https://github.com/nicknochnack/LipNet de Nicholas Renotte ou autre lien https://github.com/VIPL-Audio-Visual-Speech-Understanding/LipNet-PyTorch.

Références :

LIPNET: END-TO-END SENTENCE-LEVEL LIPREADING https://arxiv.org/pdf/1611.01599

Exemple de détection de face : https://github.com/1adrianb/face-alignment

A partir de ces approches, l’objectif dans RePhon-IA est d’adapter ces méthodes dans notre contexte pour compléter l’analyse des erreurs de l’apprenant. Plusieurs difficultés restent à surmonter dans cette approche : détecter la position de la bouche, l’apprenant peut au cours de la séance bouger ce qui doit être pris en compte dans l’analyse.